在边缘AI应用逐步普及的今天,如何让AI模型在端侧快速、高效地运行,成为开发者普遍关注的核心问题。面对复杂的AI算法与算力需求,RK1820作为一款集成RISC-V协处理器与高性能AI加速引擎的SoC,为开发者提供了一套完整、易用的端到端AI开发体系。

本文将带你深入解析RK1820的开发框架,从PC端模型开发到板端AI部署,看看Neardi如何让AI协处理器真正“落地”。

在嵌入式系统和 AI 加速场景下,主控芯片负责通用控制与资源管理,协处理器则承担高强度、专用或实时的计算任务。通过共享内存、FIFO、RPC 等机制实现高效协同,能够显著提升系统性能、降低功耗并保持设计的灵活可扩展性,这也是现代 SoC 越来越多采用协处理器架构的根本原因。RK1820是一款AI协处理器, 与RK3588/RK3576相结合, 通过PCIe通信能灵活、快速的、高效地使用。

角色 | 功能定位 | 典型芯片 |

主控SOC(Host) | 系统调度、外设管理、任务分配、应用逻辑执行 | RK3588、RK3576、RK3568 |

协处理器(Device) | 负责特定类型的计算加速(如AI推理、加密、图像处理) | RK1820、RK1808、BM1684X、Hailo-8 |

PCIe(通信接口) | 实现主控与协处理器之间的低延迟、高带宽数据交互。 | - |

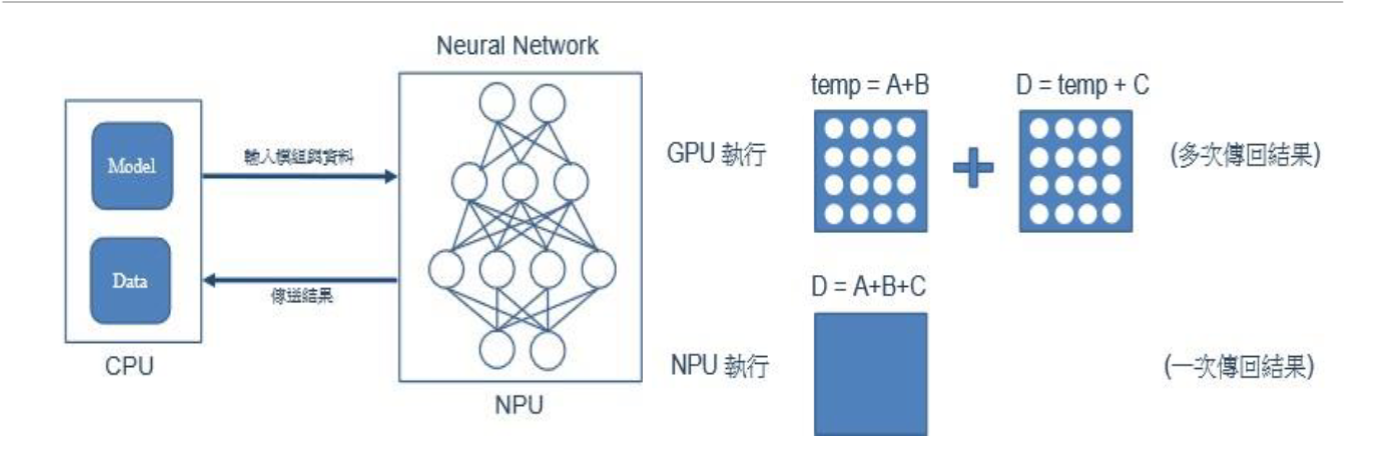

主控芯片(CPU)在嵌入式系统中的职责 CPU 负责“让系统按正确顺序、在正确时间、以最低能耗完成感知、计算、通信、控制”的全部杂活;其他专用引擎(NPU、DSP、FPGA 协核)只负责“算得快”,但什么时候算、算什么、算完给谁,都得听 CPU 指挥。

CPU 就是嵌入式系统的“全能管家”:它一边读程序、一边把指令翻译成真正要做的运算,还让 ALU 去把活干完;同时操心内存、缓存、时钟怎么分才公平,像财务总监一样盯着有限的资源。对外,GPIO、UART、I²C、SPI、USB、网口都是它的“嘴”和“手”,传感器、屏幕、网络模块想通信都得先找它。任务多了,它立刻变项目经理,在 RTOS 里按优先级切时间片,保证电机、刹车这类急件秒级响应。上电那一刻,它先自检、再拉 Bootloader 验身份,确认系统“干净”才放行。发现系统空闲,就自动降频降压甚至睡觉,帮电池续命。最后,它还是“总指挥”——DSP、NPU 这些外挂算力什么时候开工、搬什么数据、结果放哪,全听它一声令下;整条计算、存储、外设、加速器的流水线,都在它手里协调得明明白白。

协处理器的概念与工作原理

协处理器(coprocessor)就是“CPU 的外挂技能包”:自身不能独立取指跑操作系统,只接受主 CPU 下达的微指令或数据块,在专用硬件阵列上把特定算子(乘加、卷积、浮点、FFT、AES、CRC、三角函数……)干到高性能/低功耗,算完把结果扔回公共存储器并中断通知 CPU。编译器先“打标签”:把程序里那些算矩阵、做卷积之类的大块头函数,标成“这活儿让外挂干”。CPU 读到这些标记后,不自己硬算,而是把参数丢进协处理器的“收件箱”——可能是几个寄存器,也可能是 FIFO 或 DMA 缓冲区——然后按一下“开始”按钮。

接下来,协处理器在自己的时钟域里全速开工,CPU 则该干嘛干嘛,两边真正并行。

等协处理器算完,它会通过三种方式喊一声“我好了”:拉高某个状态位、发中断,或者把结果直接写回共享内存。CPU 收到信号后,过来把结果取走,程序继续往下走。

万一协处理器出了岔子(溢出、非法指令啥的),它会先把错误码写在状态寄存器里,再向 CPU 报异常;CPU 一看异常向量,就知道该怎么收场。整个过程就像老板把图纸递给专职机器,机器轰隆隆加工,老板继续接电话,机器做完按铃交货,有故障就亮红灯,流程顺畅又省心。

主控芯片与协处理器之间是如何通信的?为了让两者高效协作,它们之间通常通过高速互联总线进行通信,最常见的通信方式 PCIe PCIe 是一种点对点的高速串行总线标准,具有 高带宽、低延迟、可扩展性强 的特性,因此成为 CPU、GPU、NPU 等高性能器件之间通信的首选。

数据带宽高:每通道(x1)速率可达1 GB/s(PCIe 3.0)甚至 4 GB/s(PCIe 4.0),低延迟:点对点架构减少了仲裁与等待时间,适合实时AI数据交换。双向传输:全双工通道同时支持发送与接收,保证数据同步。热插拔特性:部分设计中支持模块级热插拔,方便维护与扩展。

PCIe 3.0 x4 | PCIe 4.0 x4 | USB 3.2 Gen2×1 | |

理论带宽 | 32 Gbps(≈3.94 GB/s 单工) | 64 Gbps(≈7.88 GB/s 单工) | 10 Gbps(≈1.25 GB/s 双工) |

实测持续吞吐 | 3.5 GB/s 读 / 3.0 GB/s 写 | 7.0 GB/s 读 / 6.5 GB/s 写 | 1.05 GB/s 读 / 0.95 GB/s 写 |

接口延迟 | 3–5 µs(DMA 直写) | 3–5 µs | 120–250 µs(主从调度) |

最大抖动 | <1 % | <1 % | 10–20 %(总线竞争) |

拓扑结构 | 点对点,独占通道 | 点对点,独占通道 | 主从星型,多设备共享 |

可靠性机制 | LCRC + AER 错误报告,可纠错 | LCRC + AER 错误报告,可纠错 | CRC16 + 重传,无 AER |

热插拔 | 支持,即插即用 | 支持,即插即用 | 支持,即插即用 |

实时控制 | 纳秒–微秒级闭环,抖动极低 | 纳秒–微秒级闭环,抖动极低 | 毫秒级,抖动大 |

RK1820的开发框架全解析

PC端开发环境:从训练到模型转换

在AI模型开发的初期,PC端主要承担模型训练、转换与性能评估等任务。RK1820提供了一整套成熟的软件工具链,包括:

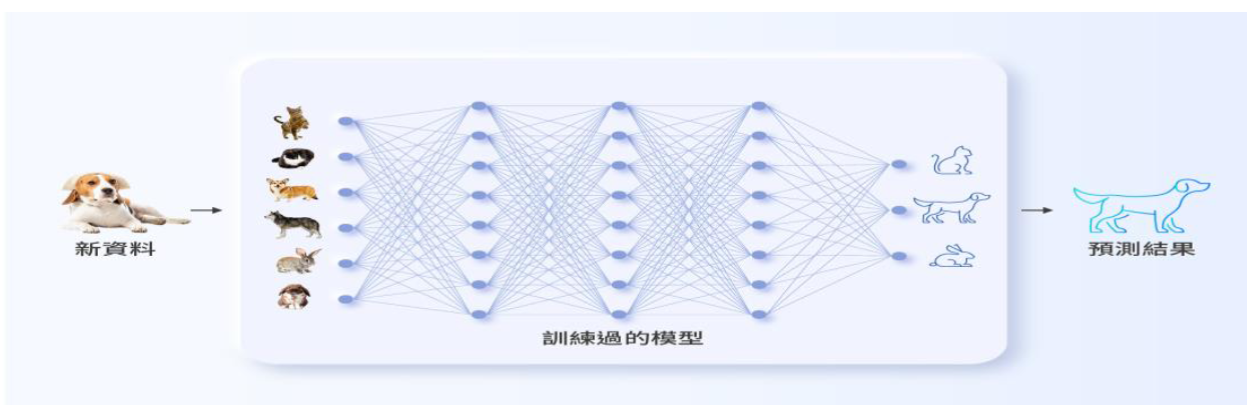

RKNN3 Toolkit - 模型转换与性能评估核心工具,RKNN Toolkit 是Rockchip推出的AI模型开发工具包,可支持从主流深度学习框架(如 PyTorch、TensorFlow、ONNX)导出的模型进行一键转换为 RKNN 格式。开发者可利用该工具完成:模型格式转换(PyTorch → RKNN)、推理性能分析与优化、精度与速度权衡评估。这一过程使模型能够充分适配RK1820的硬件加速特性,实现最大化算力释放。

RKNN3 Model Zoo - 开箱即用的AI模型仓库,Rockchip官方提供了丰富的AI模型示例库,包括图像分类、目标检测、语义分割、手势识别、人脸识别等多种类型。开发者可直接调用或基于这些模型进行二次开发,大幅缩短AI项目从“概念”到“产品”的落地周期。

板端开发环境:让模型真正跑起来

模型完成转换后,就可以部署到RK1820协处理器上进行推理执行。Neardi在RK1820平台上,提供了完善的板端开发支持,包括:

RKNN3 Runtime - 模型推理执行引擎,在端侧运行阶段,RKNN3 Runtime提供完整的API接口,支持开发者在应用中加载和执行RKNN模型。除RKNN3 API外,RK1820平台还支持OpenAI兼容API调用LLM模型,这意味着开发者可以在嵌入式设备上尝试运行轻量化的大模型应用。

Examples - 丰富的AI应用参考示例

Neardi为RK1820平台提供多种AI应用示例,如智能摄像头、人脸识别、目标检测、手势控制、OCR识别等。这些示例不仅展示了AI模型在RK1820上的性能表现,也帮助开发者快速理解API调用流程与模型部署细节。

Neardi在开发套件中集成了调试与性能工具:

RKNN-SMI:实时监控NPU使用率与运行状态;

RKNN Console:命令行工具,用于模型加载、推理测试与性能对比。

驱动支持,RK1820协处理器通过PCIe或USB高速接口与主控SoC互联,并提供完整的 RK182X PCIe EP驱动 与配套固件支持。

这种主从协同架构让主控芯片负责任务调度、I/O管理,而RK1820专注于AI推理加速,在功耗与算力之间实现理想平衡。